Vibe Coding 时代的到来:为什么需要增强搜索?

随着大模型能力的显著提升,Vibe Coding 正在成为一种流行的开发方式。开发者通过自然语言描述需求,让 AI 生成代码,从而大幅提高开发效率。然而,这种新的编程范式也带来了新的挑战:如何确保 AI 生成的代码既准确又安全?Vibe Coding 的核心挑战

在 Vibe Coding 实践中,开发者面临两个关键问题:- 知识时效性:AI 模型基于训练时的数据,无法获取最新的 API 更新、库版本变化

- 代码准确性:AI 可能生成看似合理但实际错误的代码,导致运行时错误

传统解决方案的不足

- 手动搜索:开发者需要频繁切换上下文,效率低下

- 文档查阅:需要大量时间查找和验证信息

- 社区问答:信息质量参差不齐,时效性差

工具在 Vibe Coding 工作流中的作用

Exa.ai:为 AI 代理设计的搜索引擎

核心理念

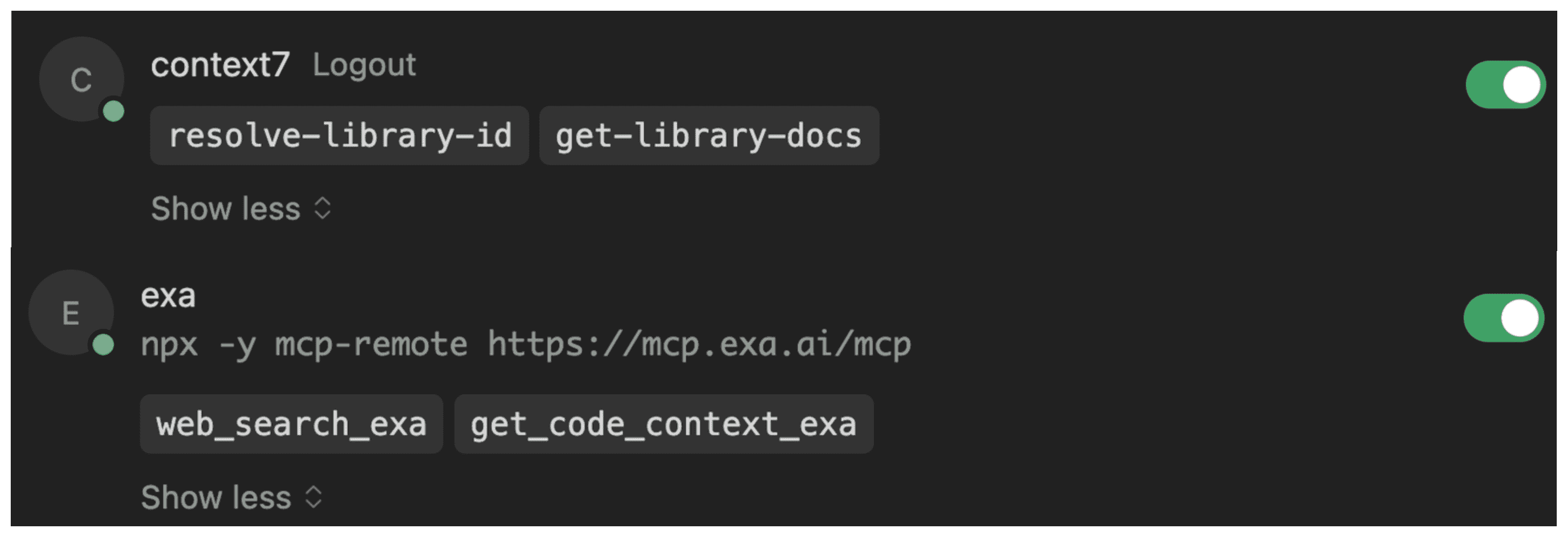

Exa.ai 重新构想了搜索引擎,专门为 AI 代理优化,而非人类用户。它提供结构化、token 高效的结果,直接为 LLM 消费而设计。核心工具链

1. web_search_exa

- 功能:实时网络搜索,突破 LLM 知识截止日期

- 适用场景:获取最新信息、时事、技术动态

- 示例:“WebAssembly 的最新发展是什么?“

2. get_code_context_exa

- 功能:代码发现引擎,搜索数十亿 GitHub 仓库和技术资源

- 特点:返回精确、token 高效的代码片段和实现模式

- 适用场景:复杂实现问题、API 使用示例

- 示例:“React hooks 与 TypeScript 结合使用的示例”

3. 专业工具

- deep_researcher:深度综合研究

- company_research:商业情报收集

- linkedin_search:LinkedIn 平台搜索

Context7:精确性专家

核心理念

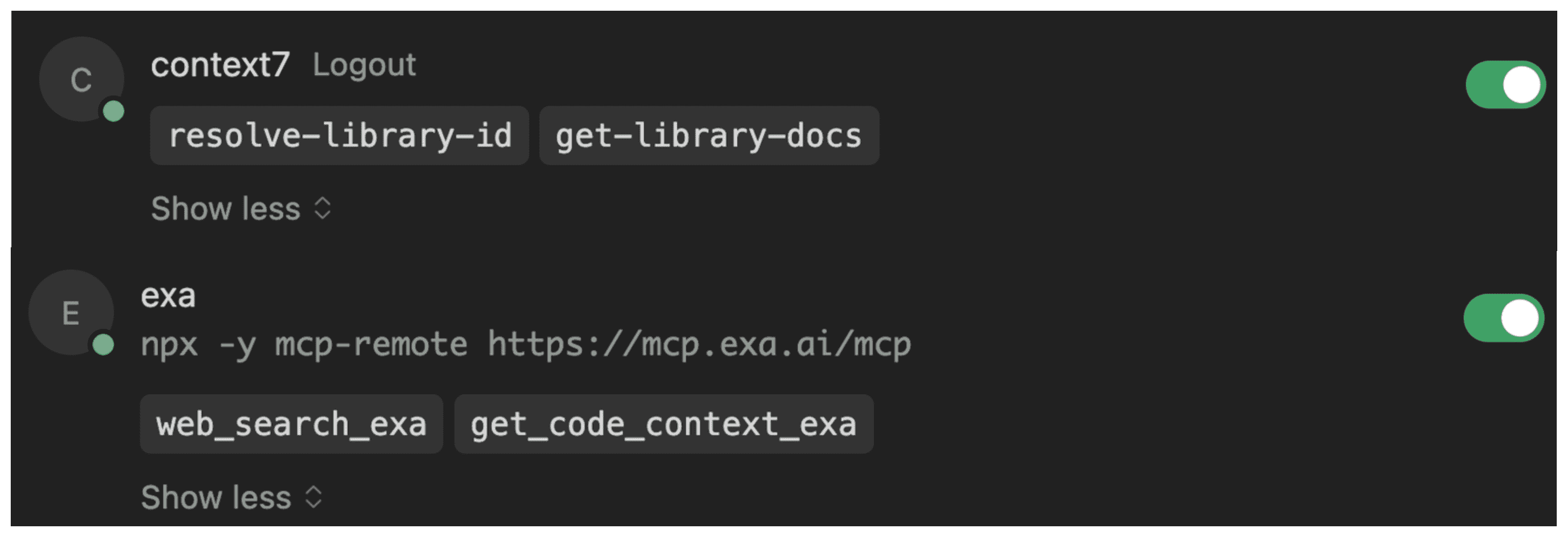

Context7 专注于消除 LLM 幻觉,通过提供准确、最新、版本特定的官方文档,确保代码生成的正确性。核心工具链

1. resolve-library-id

- 功能:消除库名称歧义,解析为精确标识符

- 示例:“Next.js” → “/vercel/next.js”

- 价值:防止相似名称库之间的混淆

2. get-library-docs

- 功能:检索权威、版本特定的文档

- 特点:支持主题过滤、token 限制

- 优势:确保 LLM 获得准确、简洁的上下文

3. 工作流程

- 触发:开发者使用 “use context7” 命令

- 解析:系统识别并解析库 ID

- 检索:获取相关、准确的文档

- 生成:基于权威信息生成代码

详细对比分析

核心差异对比表

| 维度 | Exa.ai | Context7 |

|---|---|---|

| 主要目标 | 信息发现与探索 | 事实准确性与防止幻觉 |

| 数据源 | 实时网络、GitHub、LinkedIn 等 | 精心策划的官方软件文档 |

| 覆盖范围 | 广泛、网络规模、非结构化 | 狭窄、特定于库、结构化 |

| 解决的核心问题 | LLM 知识截止;寻找新信息 | LLM 依赖过时数据;API 误用 |

| 核心工具 | web_search, get_code_context, deep_researcher | resolve-library-id, get-library-docs |

| 典型用例 | ”查找使用 Rust 进行机器学习的示例" | "展示 Next.js 14 中间件的正确语法” |

| 交互模式 | 探索性查询 | 目标性调用 |

| 输出特点 | 多样化视角、多个示例 | 单一权威、精确答案 |

| 适用场景 | 研究、探索、学习新技术 | 精确实现、API 使用 |

结论

在 Vibe Coding 时代,开发者需要的是能够快速探索、准确实现的工具。Exa.ai 和 Context7 代表了 AI 辅助开发的两个重要方向:发现与精确性。 虽然两者都很优秀,但 Exa.ai MCP Server 更适合 Vibe Coding 的需求。-

更广的覆盖范围

- Context7 专注于精选的官方文档库

- Exa.ai 覆盖整个网络,包括 Context7 索引的内容,以及博客、论坛、GitHub 讨论等

-

实时性优势

- 技术发展迅速,需要最新的信息支持

- Exa.ai 提供实时网络搜索,捕捉最新的技术动态和社区讨论

扩展阅读:专业 MCP 工具

除了通用工具,还有框架专用的 MCP 服务器,如 Shadcn MCP,专门维护特定技术栈的 AI 扩展工具,可以:- 浏览可用组件

- 搜索特定组件

- 使用自然语言直接安装到项目中